AR HUD 시스템을 설계하고 개발할 때 고려해야 할 사항들이 많다. 그 고려사항 중 우선되어야 하는 것은 운영체제와 GUI 애플리케이션, SoC 제조업체와 뉴럴 네트워크까지 포함하는 소프트웨어 등 모든 면에서의 엄격한 안전 조치다. 이에 대해 DiSTI, GlobalLogic, CoreAVI의 전문가들이 설명한다.

글 | 크리스토퍼 지오다노(Christopher Giordano) 부사장, DiSTI

야로슬라프 부블릭(Yaroslav Bublyk) AVP, GlobalLogic

루카스 프리젝(Lucas Fryzek) FAE, CoreAVI

.jpg)

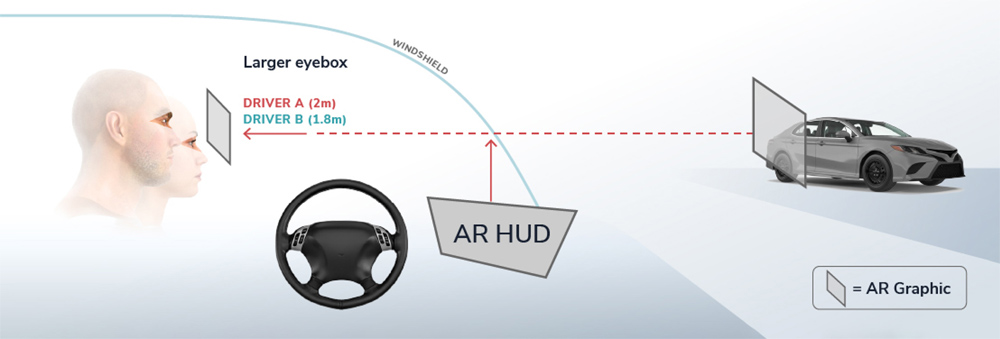

헤드업 디스플레이(HUD)의 개념은 새로운 것이 아니다. HUD는 시각적 정보를 앞 유리에 표시하는 투명 디스플레이로, 운전자가 일상적인 창밖 환경을 계속 볼 수 있도록 한다.

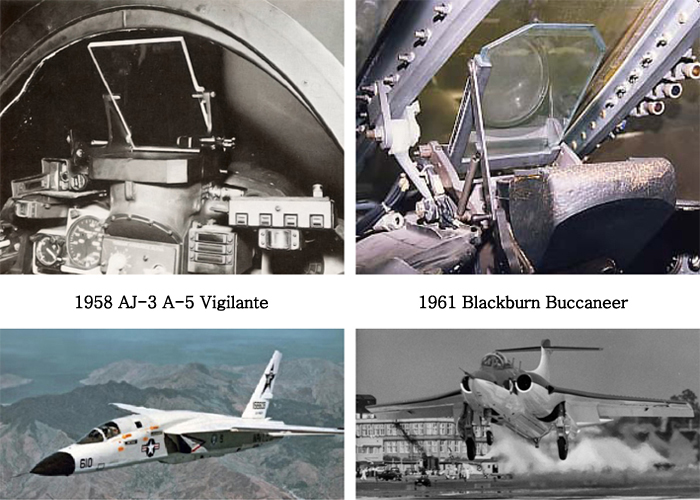

HUD의 최초 구현과 관련해서는 ‘전통적인 HUD’의 정의를 기초로 해 여전히 논쟁 중이다. HUD를 어떻게 정의하느냐에 따라, 1958년 North American Aviation의 AJ-3 A-5 Vigilant를 최초의 구현으로 보는 경우가 있고, 1961년 Elliot flight Automation의 Blackburn Buccaneer를 최초로 보기도 한다. 두 경우 모두, HUD는 중요 비행 데이터를 파일럿의 시야 내에 집중시키는 것을 목적으로 해 만들어진 것으로 국방 항공 분야가 시작이다. 이 접근 방식은 ‘작업 포화도’와 정보 과부하를 줄임과 동시에 파일럿의 스캔 효율을 높이는 것이었다.

HUD는 오늘날 자동차 시스템 요구사항으로 자리 잡기 시작한 증강현실(AR) HUD의 선구 기술이다. AR HUD 시스템은 실제 환경과 통합된 것처럼 보이도록 정보를 투사해 운전자에게 환경 스캔 효율성을 제공하는 동시에 인지 부하를 줄여준다.

AR HUD 기술은 현재 급속한 성장세에 있지만, 아직 양산 자동차에 완벽하게 구현되지는 않고 있다. HUD 시장은 매우 커지고 있다. 2019년 현재 시장은 9억 3,000만 달러 가치에 달하고 있으며, 2026년까지 거의 25억 달러로 증가할 것으로 예상된다. 2020~2026년 동안 17.3%의 연평균 성장률(CAGR)이 기대된다(1). AR 시장은 CAGR 46.3%로 더욱 폭발적으로 성장해 2026년까지 890억 달러에 이를 전망이다(2).

AR HUD의 목표는 운전자의 주의분산을 최소화하면서 운전 경험을 향상시키기 위한 중요 데이터를 제공하는 것이다. 차선 지원, 적응형 순항제어, 전방충돌 경고, 보행자/자전거 감지, 내비게이션 힌트 및 경고와 같은 첨단 운전자 지원 시스템(ADAS) 정보는 이미 2021년 양산 차량에 적용되고 있다. 하지만 2D 또는 3D POI(Point of Interest) 정보는 아직 양산 차에 널리 사용되지 않고 있다. 메르세데스 벤츠는 9월 출시될 새로운 2021 S-Class 세단에 이 기술을 적용하는 최초의 OEM이 될 것으로 예상된다. 이 브랜드의 플래그십 세단은 다른 여러 기술 업그레이드 중에서 AR HUD를 포함해 제공한다(3). 최신 AR HUD는 앞 유리에 투사되는 POI 정보를 구현함과 동시에 OEM으로 하여금 시장에 나와 있지 않은 특별한 기능을 구현하는 역량을 제공함으로써 운전 경험을 향상시킬 수 있다.

AR HUD 시스템을 성공적으로 구축하려면 시스템의 주요 구성요소가 어떻게 결합되는지 이해하는 것이 중요하다. 이제 이에 대해 자세히 설명한다.

AR HUD 정의

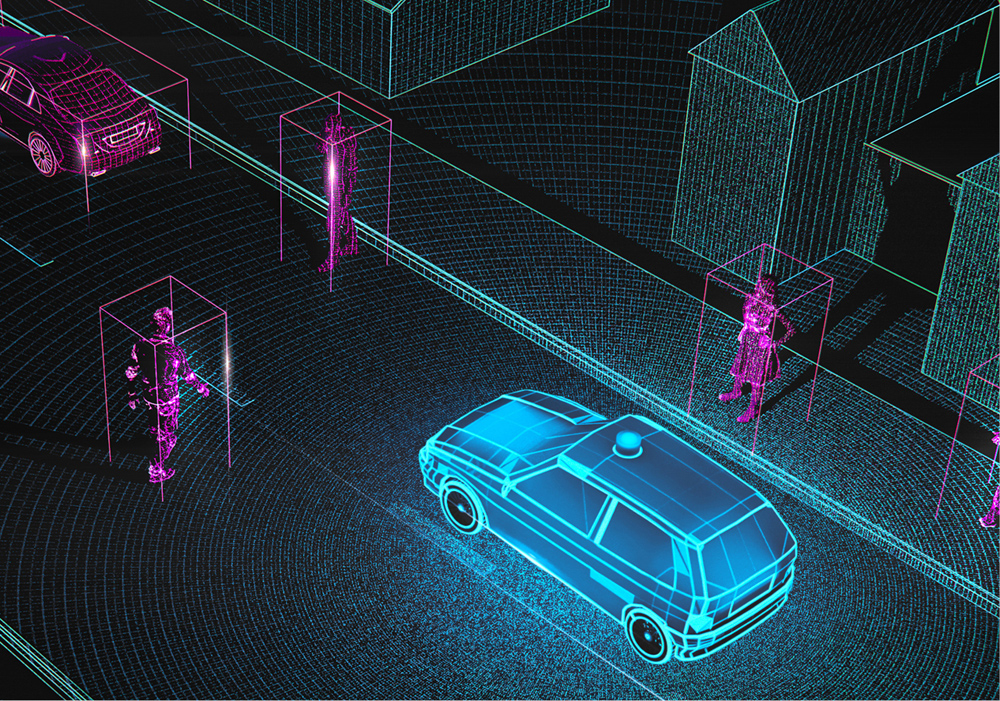

AR 엔진은 개발자가 운전자와 관련된 3D 환경에서 임의의 객체를 올바른 크기, 방향 및 위치로 스크린/디스플레이에 동적으로 배치하고 그리는데 필요한 모든 것으로 정의할 수 있다. 이러한 객체들의 세부 정보는 AR 엔진 자체로의 일부가 아니다. 세부 정보는 일반적으로 HMI의 컨텐츠 개발에 포함된다. AR 엔진은 Lidar, Range, Camera Vision이 AI 시스템에 데이터를 전송하면 AI 시스템에서 위치 및 객체 유형 정보를 계산한 후 AR 엔진을 사용해 3D 환경에서 객체를 올바르게 표시하는 HMI 애플리케이션으로 계산된 결과를 전송한다고 가정한다. 이런 모든 구성요소는 몇 가지 다른 방식으로 분류될 수 있지만, 일반적으로 AR 엔진의 구성요소는 다음과 같다.

HUD Distortion Layer는 렌즈, 거울, 앞 유리 및 기타 요소의 반사로 인해 발생하는 왜곡을 보정한다. 헤드 트랙킹 정보가 사용되는 경우, 이는 다르게 처리된다. 헤드 트랙킹을 사용하는 경우에는 Distortion Layer는 보는 위치에 따라 동적일 수 있다(예: 문 가까이로 머리를 움직일 때 앞 유리 곡선이 어떻게 변하는지 상상해보라). 이 레이어는 차량 앞에 떠 있는 것과 같은 커다란 가상 스크린을 만든다.

Spatial Calibration은 차량에 상대적인 객체의 특정 3D 위치로 특정 뷰어 위치에 대한 매트릭스 변환을 결정한다. 앞서 설명한 것처럼 헤드 트랙킹 정보가 사용되는 경우 처리 방식은 일반적으로 다르다. 이것은 다시 감지된 헤드 위치에 따라 동적으로 업데이트된다. 헤드 트래킹이 없으면 각 운전자 및 좌석 위치에 대한 간단한 보정 시퀀스가 있을 수 있다. Spatial Calibration은 카메라 매트릭스를 수정하는 것이다. 예를 들어, 지상 50피트, 측면 10피트에서 지면에 있어야 하는 마커는 해당 위치에 있는 것처럼 운전자에게 표시되므로 그것이 나타내는 실제 객체와 일치한다.

헤드 트래킹을 사용한다고 가정하면 이 고정(anchoring)은 객체의 실제 위치와 크기에 대한 운동시차(solid motion parallax) 신호를 제공함으로써 운전자가 헤드를 움직일 때 (제한 내에서) 안정적으로 보인다. 데이터 프로세싱은 객체와 위치의 지속적인 정보를 스트림으로 받음으로써 필요에 따라 3D 환경에서 3D 객체를 동적으로 생성하고 제거하기도 한다. AR 애플리케이션은 현실 세계의 객체 위에 디지털 데이터를 제공해야 한다. 이는 의미 있는 추적 마커와 함께 어려운 과제다. 뉴럴 네트워크(Neural Networks, NN)를 구현하면 NN이 훈련해 온 객체를 추적하고 분류할 수 있다. 이 위치 데이터는 뷰 변환 및 그리기를 처리하는 HMI 애플리케이션에 전달될 수 있다.

HMI Visualization는 AR HUD의 마지막 구성요소이며 AR 엔진을 통해 표시되는 시각적 객체 및 효과를 제공한다. HMI는 해당 AR 엔진 데이터를 입력으로 사용해 스크린에 보여지는 3D 환경에서 올바른 크기, 방향 및 위치를 표시하기 위한 정보를 시각적 프론트 엔드에 제공한다. 입력되는 AR 엔진 데이터를 기반으로 3D 컨텐츠가 생성되고, 배치되고, 방향이 지정되며, 구성된다. 이러한 모양에 대한 세부 사항은 고도의 사용자 정의가 가능한 고객 중심 요구사항이다. HMI는 일반적으로 원시 데이터를 처리하지 않는다. 이러한 원시 데이터는 AR 엔진으로 보내지며, AR 엔진에서는 이 데이터를 처리해 HMI 시각화 레이어로 적절한 데이터를 보낸다. HMI 레이어는 차량 시스템이 HMI가 시각적 데이터를 3D 환경에서 보여줄 필요가 있다고 결정할 때만 관여된다. 그런 다음 HMI는 지시된 위치와 방법에 따라 적절한 내용을 표시한다.

확실히 AR HUD 개발에 있어 어려움은 없다. 이 주제에 관한 많은 훌륭한 페이퍼들이 시장에 있다. 이 글의 의미는 좀 더 일반적인 개요에 가깝다. 다음은 AR HUD 개발을 연구하는데 있어 고려해야 할 약어 목록이다.

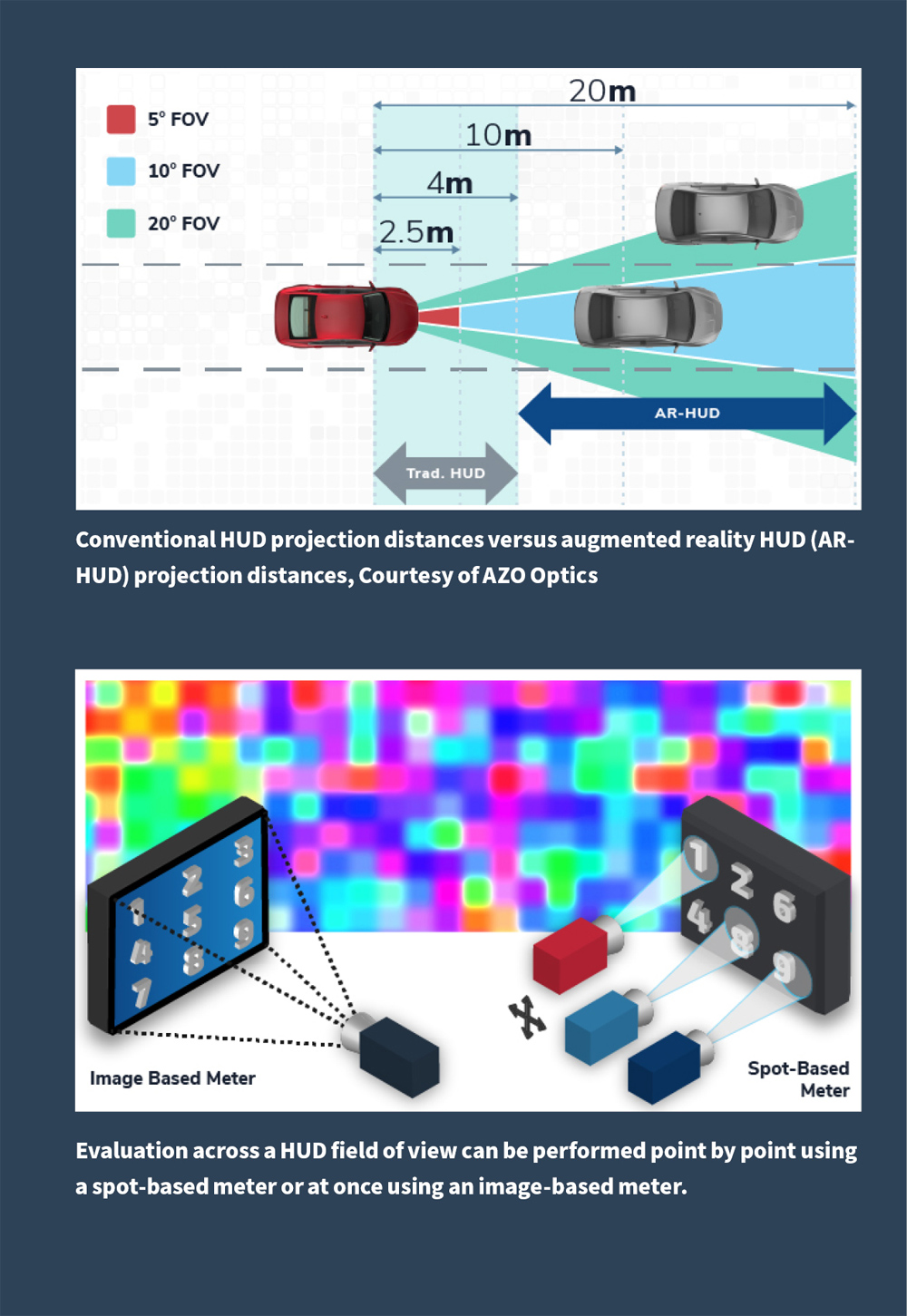

- AR HUD에 대한 FOV (Field of View) 프로젝션 요구사항

- 동일하지 않은 환경을 보정하는 동안 고스트 이미지 및 정렬 불량

- 휘도, 색도, 균일성 및 대비에 대한 측정 허용 오차 요구사항

- 실제 세계의 객체 위에 표시되는 3D 데이터와 비교해 운전자 시점 정렬

- 객체가 움직이고 지속적으로 환경에 들어오고 나가는 동안 객체 위치 및 원근 추적

- 실시간 데이터 업데이트

- 위험, 경고 및 POI를 정확하게 결정하기 위한 객체 분류 및 추적

- AR 엔진과 HMI 그래픽 영상 간의 데이터 연결 결정

- 인지 과부하를 피하기 위한 적절한 시각적 디자인

AR HUD에 대한 연구가 빠르게 확장됨에 따라 이 목록은 계속 증가할 것으로 예상된다. 위의 데이터 포인트 중 일부는 본 글의 뒷부분에서 자세히 설명하는 NN의 적절한 구현을 통해 처리될 것이며, 다른 일부는 본 글의 뒷부분에서 설명하는 기능안전성 프로세스를 통해 관리될 것이다. 양산을 목적으로 AR HUD를 개발할 때에는 모든 사항을 신중하게 고려해야 한다.

AR HUD에서 고려해야 할 기타 요소

AR HUD와 관련이 있는 V2X(Vehicle-to-Everything)는 언급할만한 또 다른 주제다. 이상적으로는 AR HUD에 사용되는 V2X는 교통 지원(예: 교통체증, 사고 알림, 결빙도로 상황) 또는 인프라 정보(예: 신호등, 터널 차선 폐쇄, 도개교 풀업/다운)를 제공하기 위해 앞 유리에 표시되는 정보를 거의 실시간으로 생성한다. 여기에는 연속 신호, 데이터 무결성 및 데이터 보안과 같은 몇 가지 문제가 있으며, 이 모든 문제는 자체적인 페이퍼의 주제가 될 수 있다.

자동차 인프라가 계속 발전하고 전기차의 채택이 더 널리 보급됨에 따라 전기차에 HUD 하드웨어를 위한 공간이 더 많아졌다는 점은 주목할 가치가 있다. 더 이상 내연엔진이나 관련 부품이 필요 없어지면서 AR HUD 시스템을 위해 더 많은 공간을 사용할 수 있다. 기존 HUD보다 더 많은 공간을 설계 프로세스 초기에 할당할 수 있어 더 많은 처리 능력을 사용할 수 있으며, 이로 인해 유연성이 향상된다. 일반적으로 전기차에는 AR HUD 지원에 필요한 ADAS 시스템이 장착돼 있으며 이를 기반으로 감지 및 투영을 위한 방법을 추가하기만 하면 된다.

AI와 뉴럴 네트워크(NN)의 역할

뉴럴 네트워크 (NN)은 컴퓨터 비전 영역에서 해결하기 매우 어려운 문제(예: 객체 분류, 객체 추적, 특수 데이터 압축 및 추상화)를 해결하기 위한 탁월한 역할을 한다. 인간이 물체를 보고 그것이 “자동차” 또는 “인간”이라는 것을 식별하는 것은 쉽지만 컴퓨터가 이를 식별하는 것은 어려울 수 있다. NN은 훈련 데이터와 예상 결과를 제공한 다음 어려운 문제를 해결하는 알고리즘을 “생성”할 수 있는 메커니즘을 제공한다.

예를 들면, LIDAR 데이터 처리의 경우 많은 LIDAR 포인트 클라우드 데이터를 입력으로 사용하고 3D 위치 데이터를 출력으로 제공하는 NN을 설계할 수 있다. 다음은 훈련 데이터를 가져와서 예상되는 출력을 수동으로 생성할 수 있다. 목표는 훈련 데이터에 지정된 대로 작동하는 알고리즘을 갖도록 훈련 데이터에 대해 NN을 훈련시키는 것이다. 이것은 높은 수준의 관점을 나타내지만 교육 과정을 지나치게 단순화할 수 있다. NN을 훈련할 때 고려해야 할 몇 가지 주요 문제가 있다. 훈련 데이터에서 네트워크를 과도하게 훈련시키면 일반 입력 데이터에서 더 이상 작동하지 않을 수 있으니 네트워크를 과도하게 훈련시키지 않는 것이 중요하다.

또한, 훈련 데이터는 다양한 입력에 걸쳐 설계돼야 한다.

뉴럴 네트워크 분야, 특히 기능안전성과 관련해 지속적으로 연구가 진행되고 있으며 이 분야는 항상 변화하고 성장하고 있다. 보다 강력하고, 보다 빠른 처리가 가능한 하드웨어를 사용하면 HMI 애플리케이션 처리에 사용되는 GPU와 같이 오늘날 차량 내부에 장착돼 있는 기존 하드웨어를 통해 NN 실행을 쉽게 가속화할 수 있다.

HMI 지원 3D AR HUD 개발

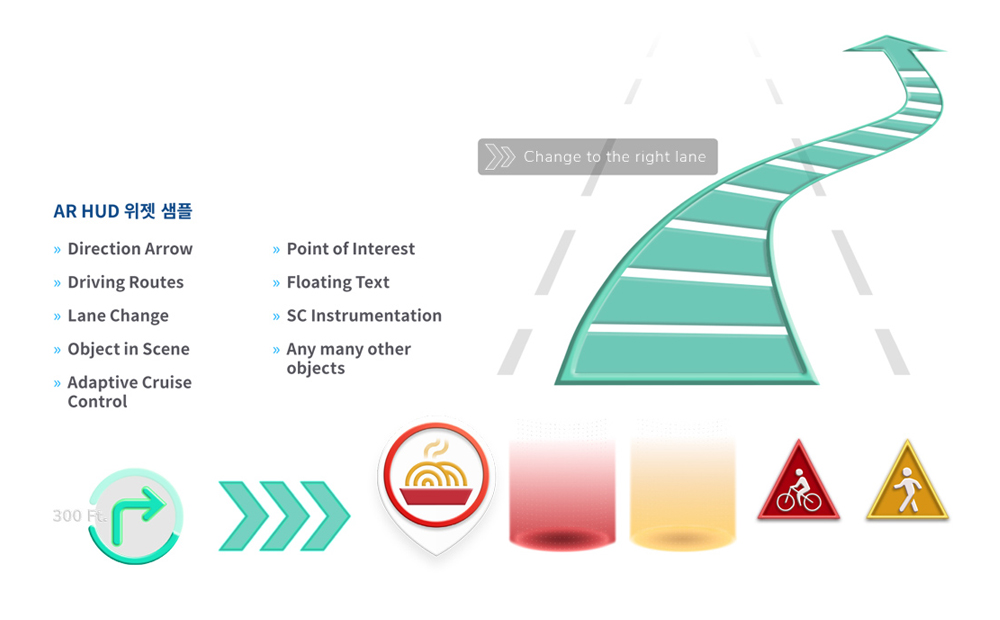

3D AR HUD HMI를 시각화하려면 3D 및 2D 구성요소의 개발이 필요하다. HMI 도구 및 프레임워크를 선택할 때 3D의 기본개념은 AR HUD의 중요한 요소가 된다. 유연성(flexibility)과 사용자 정의 가능성(customizability)은 향후 수년간 HMI의 성공적 개발을 보장하는 열쇠다. 예를 들어, GL Studio는 3D 컨텐츠를 자체적으로 지원하고 완전한 사용자 정의 기능을 갖추고 있어 모든 대화형 2D 및 3D 컨텐츠를 나타내는 재사용이 가능한 위젯을 만들 수 있다. 또한, 한 번 생성되면 프로그래밍 없이도 다른 프로젝트에서 쉽게 재사용할 수 있는 드래그 앤 드롭 형태의 객체 지향 HMI 위젯을 만들 수 있다. 이러한 수준의 유연성은 AR HUD 설계의 미래 보장, 신속한 개발, 장기적인 유지관리 및 고성능 3D HMI 컨텐츠 제작을 위한 핵심적인 요소다. GL Studio를 사용하면 AR HUD 위젯 세트를 구현해 프로그래밍 없이 다음 기능을 처리할 수 있다.

시각화된 3D AR HUD 객체를 제어하기 위해, 각 객체 유형은 데이터 입력을 처리해 원하는 HMI 모양과 효과를 표시하도록 생성된 후 AR 엔진의 데이터를 통해 배치 및 표시된다. 개발자는 GL Studio를 사용해 여러 상업용 설계 도구에서 가져온 사용자 정의된 3D 및 2D 데이터로 작업해 다양한 실시간 위젯 기능을 개발할 수 있다. 이 방법을 사용하면 개발자가 고도로 사용자 정의된 모양과 느낌을 만들 수 있으며, 개발자는 사용자 정의된 동작과 애니메이션을 빌드해 원하는 대로 3D 위젯을 제어할 수 있다. 컴포넌트가 완료되면 새로운 AR HUD HMI 컴포넌트를 재사용 가능한 위젯으로 저장할 수 있으며 프로그래머가 아닌 사람이 사용할 수 있도록 다른 프로젝트의 GL Studio 도구 모음에 추가할 수도 있다.

기능안전성이 중요한 역할을 할까

AR HUD는 가까운 미래에 자율주행 모드와 운전자 제어 간의 전환에 큰 역할을 할 가능성이 크다. 완전 자율주행 시대까지는 긴 과도기간이 있을 것으로 예상된다. AR HUD는 관련 정보를 표시할 때 자율주행 모드에서 수동 모드로의 전환을 지원하는 핵심적인 역할을 할 것이다. HMI에 대한 FuSa 고려사항은 차량이 여전히 유인이거나 자율적 기능에서 제어권 전환 이벤트(take over events) 방식의 부분 유인화인 경우에만 고려된다.

기능안전성 요소는 AR HUD에 확실히 포함될 수 있으며, 이는 전체 디스플레이보다 우선해 중요한 데이터만 표시할 수 있다. AR HUD 기술은 비교적 새로운 개념이다. 따라서 안전 관점에서 면밀한 조사, 평가 및 분석이 계속되고 있다. 수행해야 할 첫 번째 작업은 잠재적 위험의 결과가 정의되는 위험 및 위험 분석(Hazard and Risk Analysis, HARA)이다. 이러한 위험을 기반으로 적절한 안전 목표가 수립된다. AR HUD에 대한 공식적인 HARA 결과가 없으면 잠재적인 위험 및 위험의 예를 국소적으로 정의할 수 있다. 가장 명백한 위험은 앞 유리에 표시되는 이미지가 운전자의 주의를 산만하게 할 수 있다는 것이다. 이는 주변 조명이 낮은 조건에서 이미지가 깜박이거나 너무 밝으면 위험할 수 있음을 의미한다. 고려해야 할 또 다른 위험은 앞 유리에 표시된 정보가 오해의 소지가 있을 수 있는 것이다. 따라서 이는 운전자가 원하지 않는 행동을 하도록 자극할 수 있다.

ADAS 기능은 고도로 개발돼왔으며, 법률 규정(EU위원회, US DoT, NHTSA 또는 기타 국가 기관)으로 인해 매년 표준 장비로서 모든 자동차 부문에 적용되고 있다. ADAS 알림은 현재 시각적 경고 및 청각적 사운드의 형태로 계기판을 통해 운전자에게 전달된다. 향후 사용 사례의 특성상 AR HUD가 장애물 회피, 전방충돌 경고, 보행자 인식 및 기타 고려사항에 대한 안전 등의 중요한 데이터를 제공할 것임을 알 수 있다. 따라서 앞 유리에 표시되는 정보의 무결성과 신뢰성을 보장하는 것이 중요하다.

GL Studio의 ASIL-D 규정 준수는 AR HUD가 요구하는 안정성과 코드 무결성을 제공한다. AR HUD는 더 큰 가상 이미지, 늘어나는 디스플레이 장면 및 밝기로 인해 실제 세계의 객체와 겹칠 수 있어 운전자의 적절한 반응을 잠재적으로 방해할 수 있다. 여기서 기능안전성은 주간 및 야간 조건 모두에서 AR HUD의 중요한 구성요소가 된다.

AR HUD는 클러스터 기능 및 특징을 서서히 선점할 것으로 예상된다. 예를 들어 테슬라 Model 3에는 표시되는 컨텐츠(차량 속도, 텔테일)가 기능안전성 범위에 포함되지만, 전통적인 클러스터 또는 HUD가 없다.

뉴럴 네트워크 기반 알고리즘을 사용하는 경우, 기능안전성을 위해 NN의 취지와 실행이라는 두 가지 주요 측면이 나타난다. NN의 취지는 해결하기 어려운 문제이며 현재 현장에서 적극적으로 연구되고 있다. NN은 정확성을 다루고 결과를 예상된 결과와 비교해 이 문제를 해결하기 위해 잘 이해돼야 한다. NN의 실행은 현재 사용 가능한 상용 도구로 해결할 수 있다. CoreAVI의 VkCoreVXTM는 현재 뉴럴 네트워크를 위한 인증 가능한 추론 엔진(Inferencing Engine)을 제공한다. 이 추론 엔진은 Khronos OpenVXTM 표준과 OpenVX의 NN 기능 세트를 기반으로 하고 있다. Khronos는 또한 TensorFlow와 같은 NN 도구에서 개발된 뉴럴 네트워크를 가져와서 OpenVX에서 받을 수 있도록 일반적인 교환 형식으로 내보낼 수 있는 ‘뉴럴 네트워크 교환 포맷(Neural Network Exchange Format)’을 정의했다. 현재의 뉴럴 네트워크 기반 프레임워크는 안전을 고려해 설계되지 않았으며, OpenVX는 기존 작업 및 설계를 안전 필수(Safety-critical) 플랫폼으로 마이그레이션할 수 있는 경로를 제공한다. 개발자는 NN을 실행하는 데 사용되는 소프트웨어가 안전하고 기존 기능안전성 표준을 충족하는지 확인해야 한다. 소프트웨어 인증은 보다 더 잘 이해되고 있는 문제이며, CoreAVI의 VkCoreVX 및 DiSTI의 GL Studio SC와 같은 안전 요구사항을 충족하는 기능적으로 안전한 코드를 개발하는 공급업체가 해결해야 한다.

AR HUD와 기능안전성과의 관계를 고려할 때, 디스플레이 되는 컨텐츠 및 객체의 복잡성이 증가하면 안전하고 일관성을 유지하는 데 더 많은 어려움이 있음을 유념해야 한다. 프레임워크에 적합한 도구를 선택하는 것이 성공의 핵심요소다.

결론

AR HUD는 개념증명(Proof of Concept)을 통해 공격적으로 연구되고 구현되고 있는 빠르게 성장하는 분야다. AR HUD의 목표는 인지 부하를 줄이면서 운전 환경의 스캔 효율성을 제공하는 것이다. 위험 회피에서 위치 업데이트에 이르기까지, AR 기술은 변화하는 환경에 적응함과 동시에 실시간으로 중요한 정보를 전달하는 속도와 효율성을 더함으로써 운전 경험을 향상 시킬 수 있다(4).

자율주행차가 보편화 됨에 따라 모든 것이 바뀔 수 있다. 그러나 차량에 대한 수동 제어권 전환 이벤트(take over events)가 있는 한 AR HUD는 데이터를 운전자에게 제공하는 데 중요한 역할을 한다. 디스플레이는 차량의 모든 곳에 있으며 제공되는 데이터는 시간이 지날수록 더 복잡해짐에 따라 HMI의 필요성이 더 커지고 있다. 해당 데이터를 계산하고 전달하는 시스템에 대한 요구사항도 계속 증가하고 있다. 이러한 기술을 필요로 하는 소비자는 대형 물리적 화면에 표시되는 시각적으로 매력적인 그래픽 컨텐츠를 선호한다. 또한 컨텐츠는 시각적인 아름다움의 충족뿐만이 아니라 신뢰성이 중요하다. 안전 관점에서 신뢰할 수 있도록 하려면 하드웨어 및 소프트웨어 수준 모두에 특별한 방법을 적용해야 한다.

운영체제(OS)와 GUI 애플리케이션, SoC 제조업체와 소프트웨어 모두 엄격한 안전 조치를 만족해야 한다. 이 글에서 강조하는 것처럼 AR HUD 시스템을 설계하고 개발할 때 고려해야 할 사항들이 많다. 고려사항 중 우선시 되어야 하는 것은 적절한 상용도구의 채택과 당면과제에 대한 이해 및 안전하고 신뢰할 수 있는 AR HUD 시스템을 위해 기술의 위험을 줄이고 미래를 보장할 수 있는 구현 전문지식을 갖추는 것이다. [AEM]

참고문헌

1. Reports, V. (2020, July 24). Head up Display (HUD) market size is projected to REACH usd 2422.5 million by 2026 - Valuates Reports. Retrieved March 11, 2021, from https://www.prnewswire.co.uk/news-releases/head-up-display-hud-market-size-is-projected-to-reach-usd-2422-5-million-by-2026-valuates-reports-879069209.html

2. Reports, V. (2021, January). Global Augmented Reality Market - Market Research Report. Retrieved March 16, 2021, from https://www.kbvresearch.com/augmented-reality-market/

3. Gitlin, J. M. (2020, July 10). Augmented reality heads-up displays for cars are finally a real thing. Retrieved March 11, 2021, from https://arstechnica.com/cars/2020/07/augmented-reality-heads-up-displays-for-cars-are-finally-a-real-thing/

4. Elias @hariselias, H. (2020, October 09). How augmented reality (AR) HUD technology is hitting the road. Retrieved March 11, 2021, from https://techhq.com/2020/10/ar-huds-the-next-upgrade-for-connected-vehicles/

.jpg)

저자소개 /

크리스토퍼는 1997년부터 US Navy와 University of Central Florida에서 UI 및 HMI 소프트웨어 개발에 주력해 왔다. 1999년부터 DiSTI에서 60개 이상의 다양한 프로그램에서 수석 엔지니어 또는 프로그램 매니저로 근무했으며 DiSTI의 모든 UI 개발 도구에 대한 제품 매니저 역할을 해왔다. Boeing, Hyundai, Jaguar Land Rover, Lockheed, NASA, Nissan Motors, Northrop Grumman 및 The Space Ship Company를 위한 DiSTI의 HMI/UI 프로그램을 관리했으며 현재 DiSTI의 UX/UI 기술 부사장이다.

야로슬라프는 임베디드 소프트웨어 개발 분야에서 우수한 기술적 배경을 가지고 있다. 2017년부터 GlobalLogic에서 엔지니어링 담당 부사장으로 일하면서 500명 이상의 고도로 전문적인 엔지니어 팀을 관리했다. 통신, 임베디드, 산업 및 자동차 산업에서 다양한 프로그램을 이끌고 있다. 현재 ADAS, AR 및 통합 가상화 IVI/ 클러스터 솔루션 분야에서 많은 첨단 자동차 프로그램을 이끌고 있다.

루카스는 CoreAVI에서 5년 동안 소프트웨어 개발자로 일해 왔으며 최근에는 FAE 역할을 담당하고 있다. DO-178C 안전 필수(Safety-critical) 환경에 배포 가능한 임베디드 소프트웨어 시스템 개발에 많은 실무 경험이 있다. 여러 CPU 코어에 걸친 그래픽 워크로드 분할을 전문으로 하는 고객을 포함해 안전 필수 솔루션을 제공하기 위해 CoreAVI의 많은 주요 고객과 협력했다. OpenGL SC 및 Vulkan API에 대한 경험을 바탕으로 CoreAVI의 고객과 내부 팀에 전문기술 지원 및 지침을 제공한다.

AEM(오토모티브일렉트로닉스매거진)

<저작권자 © AEM. 무단전재 및 재배포 금지>